लोकसभा चुनाव में डीपफेक की समस्या बनीं नेता, दल और वोटर्स के सामने बड़ी चुनौती

डीपफेक एक ऐसी तकनीक है जिसमें आप अपनी फोटो या वीडियो में थोड़ा बदलाव करके ऐसा दिखा सकते हैं मानो आप कोई दूसरा व्यक्ति बोल रहे हों। यह सही लगता है. इस बार के लोकसभा चुनाव में भी ऐसी ही डीपफेक तकनीक का संकेत है।

डीपफेक तकनीक की मदद से चुनाव के दौरान उन राजनेताओं के भी वीडियो बनाए जाते हैं जो अब इस देश में नहीं हैं। हाल ही में दिवंगत डीएमके प्रमुख एम करुणानिधि का एक वीडियो सामने आया। इस वीडियो में करुणानिधि का स्टाइल बिल्कुल दोहराया गया है. वीडियो में उन्होंने करुणानिधि वाला काला चश्मा, सफेद शर्ट और गले में पीला दुपट्टा पहना हुआ है.

वीडियो में करुणानिधि को 8 मिनट के भाषण के साथ दिखाया गया है. इसके साथ ही टीआर बालू की आत्मकथा लॉन्च होने पर बधाई दी गई है. करुणानिधि के वीडियो का इस्तेमाल तमिलनाडु के मुख्यमंत्री एमके स्टालिन के काबिल नेतृत्व की तारीफ करने में भी की गई है. बता दें कि करुणानिधि का साल 2018 में ही निधन हो चुका है.

राजनीतिक दलों को मिल गया नया हथियार!

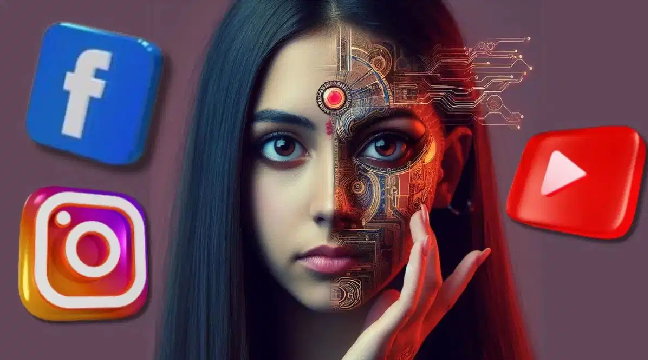

चुनाव में प्रचार के लिए राजनीतिक दल लगातार रैलियां और जनसभाएं कर रहे हैं. अब उन्हें एक नया हथियार भी मिल गया है. ये है- आर्टिफिशियल इंटेलिजेंस (एआई) यानी कृत्रिम बुद्धिमत्ता. फेसबुक, इंस्टाग्राम, यूट्यूब, एक्स जैसे सोशल मीडिया प्लेटफॉर्म पर राजनीतिक दल एआई की मदद से बने फोटो और वीडियो शेयर कर रहे हैं. इनका मकसद अपनी पार्टी के उम्मीदवारों की तारीफ करना, विरोधियों का मजाक उड़ाना या वोटरों तक सीधे मैसेज पहुंचाना हो सकता है.

चुनाव में बीजेपी, कांग्रेस समेत लगभग हर राजनीतिक दल ने अपने आधिकारिक सोशल मीडिया अकाउंट पर कम से कम चार बार आर्टिफिशियल इंटेलिजेंस (AI) के जरिए बनी हुई फोटो या वीडियो शेयर की है. इन बदले हुए फोटो या वीडियो को आम बोलचाल में ‘डीपफेक’ कहा जाता है.

एआई की मदद से किसी भी नेता की हूबहू आवाज की नकल की जा सकती है, ऐसे में नेता चुनाव में वोटर्स को रिझाने के लिए वॉइस क्लोनिंग टूल का इस्तेमाल भी कर सकते हैं. अभी तक चुनाव के वक्त हमें रिकॉर्डेड मैसेज वाले फोन आते थे, जिनमें कोई नेता वोट मांगता था. ये सब जानते हैं. लेकिन अब आर्टिफिशियल इंटेलिजेंस (AI) की मदद से कॉल की शुरुआत में ही आपका सीधे नाम लेकर भी संबोधित किया जा सकता है. ये चुनाव प्रचार को और ज्यादा निजी बना सकता है.

2014 से डीपफेक का किया जा रहा है इस्तेमाल

चुनाव प्रचार में भ्रम पैदा करने वाली तकनीकों का इस्तेमाल कोई नई बात नहीं है. रिपोर्ट के अनुसार साल 2014 से डीपफेक का इस्तेमाल किया जा रहा है. 2012 में ही बीजेपी ने नरेंद्र मोदी की 3D होलोग्राम फोटो का इस्तेमाल किया था. इस तकनीक से ऐसा लगता था कि मानो नरेंद्र मोदी एक साथ कई जगहों पर प्रचार कर रहे हैं. इसी तकनीक का इस्तेमाल 2014 आम चुनाव में भी बड़े पैमाने पर किया गया था. हालांकि आजकल डीपफेक वीडियो का इस्तेमाल किया जा रहा है.

बीजेपी सांसद मनोज तिवारी पहले नेता हैं जिन्होंने डीपफेक तकनीक का इस्तेमाल किया. फरवरी 2020 में दिल्ली विधानसभा चुनाव से पहले उन्होंने मतदाताओं को हिंदी, हरियाणवी और अंग्रेजी में संबोधित किया था. ताकि तीन अलग-अलग भाषाओं के लोगों तक उनकी बात पहुंच सकें. उनका सिर्फ हिंदी वाला भाषण असली था, बाकी दो वीडियो डीपफेक थे. एआई का इस्तेमाल करके उनकी आवाज और शब्दों को बदल दिया गया था, साथ ही उनके हाव-भाव और होठों की गति को भी बदल दिया गया था ताकि यह पहचानना लगभग नामुमकिन हो जाए कि ये असली नहीं हैं.

मतदाताओं से चुनाव की आजादी छीन लेता है डीपफेक?

30 नवंबर 2023 को तेलंगाना में विधानसभा चुनाव के लिए वोटिंग चल रही थी. मतदाता वोट डालने के लिए लाइन में खड़े थे, तभी उनके व्हाट्सअप पर एक वीडियो आता है. ये वीडियो कथित तौर पर उस वक्त के मुख्यमंत्री और भारत राष्ट्र समिति (BRS) के नेता केटी रामा राव को कांग्रेस को वोट देने की अपील करते हुए दिखा रहा था.

दरअसल, ये वीडियो डीपफेक था. मतलब ये वीडियो एआई टेक्नोलॉजी का इस्तेमाल कर बनाया गया था जिसे असली दिखाने की कोशिश की गई थी. ये इस बात का उदाहरण है कि कैसे डीपफेक चुनाव को प्रभावित कर सकता है और नागरिक किसे वोट दें ये फैसला बदला जा सकता है.

चुनाव आयोग के सामने डीपफेक की चुनौती

डीपफेक टेक्नोलॉजी का इस्तेमाल करके बनाई गई फर्जी खबरों को पहचानना बहुत मुश्किल है. आयोग के पास डीपफेक टेक्नोलॉजी से निपटने के लिए पर्याप्त संसाधन नहीं हैं. चुनाव आयोग को यह सुनिश्चित करना होगा कि अभिव्यक्ति की स्वतंत्रता का हनन न हो.

हालांकि इस साल लोकसभा चुनाव में चुनाव आयोग हजारों संवेदनशील मतदान केंद्रों पर होने वाली गड़बड़ियों को पकड़ने के लिए एआई टूल का इस्तेमाल करने की योजना बना रहा है. पोलिंग बूथ पर अगर कोई गड़बड़ी होती है, जैसे मतदान अधिकारियों की गैर-मौजूदगी या लिमिट से ज्यादा लोगों की मौजूदगी, तो ये एआई टूल तुरंत चुनाव आयोग को खबर कर देंगे.

चुनाव 2024 के लिए मेटा की कैसी है तैयारी

फेसबुक, इंस्टाग्राम, व्हाट्सअप की पेरेंट कंपनी मेटा ने हाल ही में एक ब्लॉग पोस्ट में बताया कि जल्द ही दुनियाभर के एडवरटाइजर्स को ये बताना जरूरी होगा कि क्या उन्होंने कोई राजनीतिक या सामाजिक मुद्दे पर आधारित विज्ञापन बनाने या बदलने के लिए AI इस्तेमाल किया है. साथ ही मेटा गूगल, ओपनएआई, माइक्रोसॉफ्ट, एडोब, मिडजर्नी और शटरस्टॉक जैसी कंपनियों द्वारा बनाई गई एआई तस्वीरों को पहचानने के लिए टूल्स बना रही है. अगर कोई यूजर ऐसी तस्वीरें फेसबुक, इंस्टाग्राम या थ्रेड्स पर पोस्ट करता है तो उन्हें लेबल किया जाएगा.

मेटा सुनिश्चित करने की कोशिश कर रहा है कि उनके प्लेटफॉर्म पर चुनाव से संबंधित कुछ भी गलत जानकारी न फैले. इसके लिए, पूरी दुनिया में मेटा के करीब 40,000 कर्मचारी काम कर रहे हैं. 2016 से अब तक टीम और टेक्नोलॉजी पर कंपनी 20 अरब डॉलर से भी ज्यादा खर्च कर चुकी है. इन 40 हजार लोगों में से 15,000 लोग फेसबुक, इंस्टाग्राम और थ्रेड्स पर डाले गए कंटेंट को रिव्यू करते हैं. ये रिव्यू करने वाले 70 से ज्यादा भाषाओं को समझते हैं, जिनमें भारत की 20 भाषाएं भी शामिल हैं.

मेटा ने बताया कि सोशल मीडिया पर गलत जानकारी फैलने से रोकने के लिए यूजर्स को उनका सच बताना जरूरी है. इसके लिए फरवरी से ही एक अभियान चला रहे हैं, जिसका नाम है ‘Know What’s Real’. यह अभियान लोगों को व्हाट्सएप और इंस्टाग्राम पर गलत जानकारी को पहचानने के बारे में सिखाता है.

दुनिया के टॉप सिक्योरिटी एक्सपर्ट्स भी जाहिर कर चुके हैं चिंता

26 सिक्योरिटी एक्सपर्ट्स ने मिलकर बीते साल एक रिपोर्ट तैयार की थी, जिसमें उन्होंने अगले दस सालों में एआई से होने वाले संभावित दुष्पर्चार को लेकर चेतावनी दी है. उनका कहना है कि वॉइस क्लोनिंग और डीपफेक टूल से बनाए गए फोटो वीडियो का इस्तेमाल चुनाव में मतदाताओं की राय बदलने के लिए किया जा सकता है. सोशल मीडिया और खबरों में फर्जी जानकारी फैलाने वाले ‘बॉट्स’ चुनाव को भी प्रभावित कर सकते हैं.

100 पन्नों की ये रिपोर्ट बताती है कि एआई के गलत इस्तेमाल से खासतौर पर तीन तरह की सुरक्षा खतरे में पड़ सकती है- डिजिटल सुरक्षा, शारीरिक सुरक्षा और राजनीतिक सुरक्षा. रिपोर्ट के मुताबिक, एआई का इस्तेमाल करके जनता की राय को बड़े पैमाने पर मनचाहे तरीके से मोड़ा जा सकता है. बिल्कुल असली लगने वाले फर्जी वीडियो को खास लोगों तक फैलाया जा सकता है.

क्या कहता है कानून

भारत में अभी तक ऐसा कोई खास कानून नहीं है जो सिर्फ एआई या डीपफेक टेक्नॉलॉजी इस्तेमाल करने वाले और उसे बनाने वाले लोगों को सजा देने की बात करता है. मौजूदा कानून व्यवस्था के तहत किसी व्यक्ति पर तब तक फर्जी खबर फैलाने के लिए मुकदमा नहीं चलाया जा सकता जब तक कि भारत की संप्रभुता, एकता या अखंडता के लिए खतरा न हो.

हालांकि फिर भी गलत जानकारी फैलाने या किसी को बदनाम करने के आरोप में मौजूदा कानून भारतीय दंड संहिता 1860, नया कानून भारतीय न्याय संहिता 2023, इंफॉरमेशन टेक्नोलॉजी एक्ट 2000 या आईटी नियम 2021 के तहत कार्रवाई की जा सकती है.

आने वाले समय में डीपफेक एक बड़ी समस्या बन सकता है. इसलिए जरूरी है कि हम सोशल मीडिया पर देखी जाने वाली हर पोस्ट पर तुरंत भरोसा न करें. पहले जानकारी को अच्छी तरह से परखें, उसके बाद ही भरोसा करें.